AI爆火,英伟达GPU芯片利润高达1000%,还供不应求!了解为什么英伟达GPU芯片如此受欢迎

不仅在国外火,在国内也火,按照机构的统计,仅国内的AI大模型就高达上百个,而全球已经有超过500个AI大模型在推进。

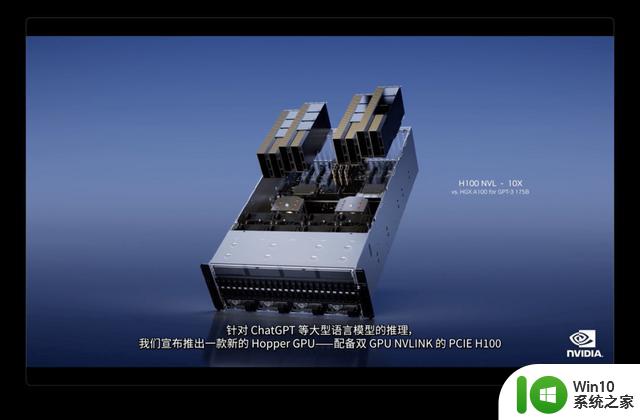

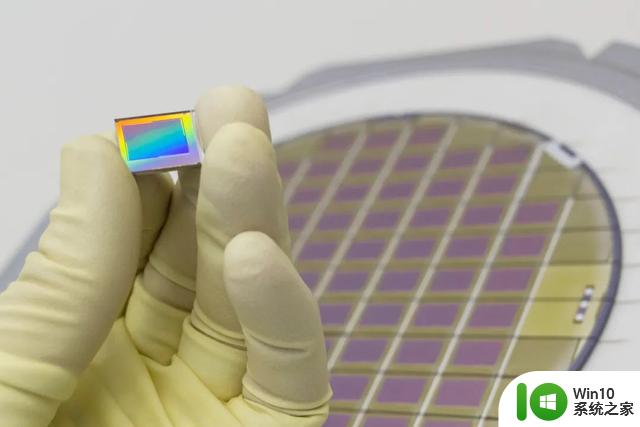

而AI大模型背后,需要的就是GPU显卡,且主要就是英伟达的GPU,特别是A100、H100这些。

按照说法,GPT-4可能在大约10000-25000张A100上进行了训练,而根据马斯克的说法,GPT-5可能需要30000-50000个H100。

之前有机构表示,OpenAI一天的花费就是70万美元,也就是500万1天,如果融不到钱,也许2024年就得倒闭,可见搞AI大模型到底有多烧钱。

而AI大模型有多烧钱,就代表着英伟达有多赚钱。

目前在市场上,像A100是一卡难求,而在国内由于A100被美国禁售,只有阉割版的A800,但也是一卡难求,涨价涨至天际。

而最新的H100,更是火爆的不得了。据称目前价格已经被炒至3万美元左右,而实际上其物料成本预计只有3000美元,也就是说利润高达10倍,利润率高达1000%!

当然,这么简单粗暴的直接按物料成本来算利润,是不合理的,毕竟像H100被研发出来,还要考虑研发成本,研发人员的工资等等这些物料之外的成本。但不可否认的是,英伟达的利润是真的高。

这也是为什么,像intel、AMD等厂商。在今年亏的这么惨,而英伟达则业绩飙涨,原因就是GPU芯片太火爆了,目前nvidia的市值超过1万亿美元,也是全球唯一一家市值过万亿美元的芯片企业。

不过也有人表示,目前别看AI大模型这么火。但最终能够活下来的可能不会超过10%,另外的90%都会倒掉,到时候全球的GPU芯片都会过剩,然后整个GPU市场都会雪崩。

未来会不会是这样,谁也不清楚,但这并不重要,不管市场雪崩不雪崩,英伟达的钱已经赚到手了,崩了又如何,不崩又如何呢?

AI爆火,英伟达GPU芯片利润高达1000%,还供不应求!了解为什么英伟达GPU芯片如此受欢迎相关教程

- 英伟达回应花莲地震:GPU芯片供应不受影响硅基世界

- 叫板英伟达 AMD斥巨资收购达智通,AMD欲借此成为芯片巨头

- 台积电打脸英伟达:AI撑不起芯片大盘,市场对AI芯片的需求降低

- 英伟达自己超越自己,H200取代H100成为新的最强AI芯片

- AI芯片先开挂,AMD要追赶英伟达,谁能在AI市场占得先机?

- 微软自研AI芯片“雅典娜”浮出水面,欲打破英伟达算力垄断

- 英伟达硬件路线图曝光:明后年将推出多款升级版AI芯片

- 英伟达再追单AI芯片,台积电紧急增购封装设备

- 美国禁止英伟达GPU,华为却迎来“泼天富贵” - 惊人转机!

- OpenAI喊话英伟达,GPU严重不够!硬件需求迎来共振;谷歌携StyleDrop炸场AI作图圈;微软年底将windows全面AI化 | 见智研究

- 甜品卡将至!英伟达RTX 4060 Ti显卡“AD106-350”GPU照片曝光

- 1530亿晶体管芯片发布,AMD正式叫板英伟达,开启全新竞争格局

- 全球债市遭抛售,恒指或创新高,马士基业绩超预期

- 高通骁龙8至尊版发布,性能媲美桌面处理器,决胜AI时代的关键!

- 高通骁龙8至尊版发布:二代自研CPU性能逆天,最强AI更像真人

- 一个印度人救了微软,另一个毁了IBM?探讨印度人在科技行业的影响力

微软新闻推荐

- 1 高通骁龙8至尊版发布:二代自研CPU性能逆天,最强AI更像真人

- 2 英特尔AMD史诗级合作,捍卫X86生态:两大巨头联手,颠覆传统CPU格局

- 3 微信消失在桌面了,怎么找回 微信桌面快捷方式消失怎么恢复

- 4 打印机的纸怎么放进去 打印机纸盒放纸技巧

- 5 onedrive开始菜单 Win10如何设置Onedrive开启和使用

- 6 台式电脑如何连接打印机设备打印 台式电脑如何设置本地打印机

- 7 惠普笔记本win11移动硬盘怎么用 win11系统移动硬盘插入后不显示

- 8 微软称每天有超过15000条恶意QR码信息被发送到教育目标,如何有效应对?

- 9 win10系统电脑没有wifi选项 Win10无线网络不显示解决方法

- 10 win7能看见的文件夹win10看不到 win7可以访问win10但win10无法访问win7

win10系统推荐

- 1 番茄家园ghost win10 32位官方最新版下载v2023.12

- 2 萝卜家园ghost win10 32位安装稳定版下载v2023.12

- 3 电脑公司ghost win10 64位专业免激活版v2023.12

- 4 番茄家园ghost win10 32位旗舰破解版v2023.12

- 5 索尼笔记本ghost win10 64位原版正式版v2023.12

- 6 系统之家ghost win10 64位u盘家庭版v2023.12

- 7 电脑公司ghost win10 64位官方破解版v2023.12

- 8 系统之家windows10 64位原版安装版v2023.12

- 9 深度技术ghost win10 64位极速稳定版v2023.12

- 10 雨林木风ghost win10 64位专业旗舰版v2023.12

系统教程推荐

- 1 蜘蛛侠:暗影之网win10无法运行解决方法 蜘蛛侠暗影之网win10闪退解决方法

- 2 win10玩只狼:影逝二度游戏卡顿什么原因 win10玩只狼:影逝二度游戏卡顿的处理方法 win10只狼影逝二度游戏卡顿解决方法

- 3 U盘装机提示Error 15:File Not Found怎么解决 U盘装机Error 15怎么解决

- 4 《极品飞车13:变速》win10无法启动解决方法 极品飞车13变速win10闪退解决方法

- 5 window7电脑开机stop:c000021a{fata systemerror}蓝屏修复方法 Windows7电脑开机蓝屏stop c000021a错误修复方法

- 6 win10桌面图标设置没有权限访问如何处理 Win10桌面图标权限访问被拒绝怎么办

- 7 win10打不开应用商店一直转圈修复方法 win10应用商店打不开怎么办

- 8 无线网络手机能连上电脑连不上怎么办 无线网络手机连接电脑失败怎么解决

- 9 win10错误代码0xc0000098开不了机修复方法 win10系统启动错误代码0xc0000098怎么办

- 10 笔记本win10系统网络显示小地球只有飞行模式如何恢复 笔记本win10系统网络无法连接小地球图标灰色